필자주: 이 글은 2025년 7월 23~25일 3일간 방콕에서 열린 Google Search Central Deep Dive가 어떤 배경에서 준비된 것인지 필자가 추정한 내용입니다. 필자는 검색엔진을 리버스 엔지니어링 하는 어센트코리아의 접근 방식하에, Google이 발행한 공식 문서와 비디오 클립 등과 이번 행사 현장의 각종 발표자료에 기반하여 ‘왜’를 추정하였습니다.

Cost Center Google Search

Google Search 부문은 돈을 버는 조직(Profit Center)이 아닙니다. 돈은 광고나 기업대상 비즈니스 등 옆 부분에서 벌죠. 고객사, 혹은 잠재고객사를 대상으로 행사를 많이 수행하는 곳은 돈을 버는 부서입니다. 광고 상품을 소개하는 Google의 행사는 자주 개최되고 기업의 광고 담당자나 광고 대행사, 기획사 등에서 빈번하게 접할 수 있는 행사입니다.

하지만 Search 업무는 돈을 벌지 않으므로(Cost Center) 사람들을 모아 놓고 돈을 쓰기 쉽지 않습니다. Youtube Search Central 채널에서 이 행사를 준비한 실무자들(Search Advocate인 Cherry & Gary가 행사 준비에 관련된 클립(Launching Search Central Live Deep Dive)에서 예산을 받기 힘들고 예산이 풍족하지 않아 힘들다는 이야기를 합니다(회사는 다 똑같죠 ). 돈버는 부서도 아닌데 행사를 주최한 것은 행사의 의미가 내부에 잘 설득되었다는 것이고, 이들은 그만큼 “절박한” 이슈가 있었다는거죠. 물론 SEO 커뮤니티가 열광적으로 참여했다는 것이 큰 동기부여이긴 했지만 비즈니스적으로 비용을 쓴 것이 이상의 효과를 기대하기 때문에 이 행사를 수행한 것이죠.

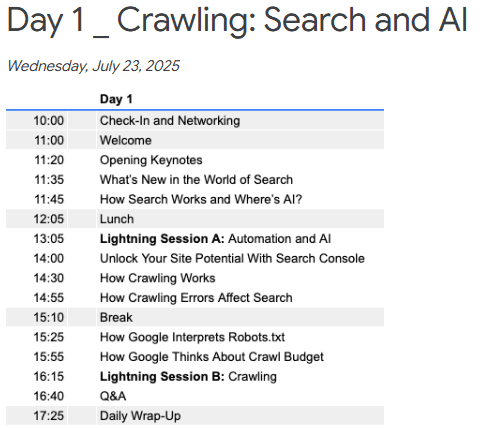

이 행사의 내용은, 아래 그림처럼, ‘Google Search가 어떻게 움직이는지 알려주마’로 가득 채워져 있습니다. 행사 내용을 이끌어간 Gary가 말합니다. ‘Google Search는 돈을 받지 않아요. 돈받고 뭘 바꿔주거나 하지도 않아요. 우린 절대 돈을 받지 않아요!’. 청중들은 같이 웃으며 그 당연한 이야기를 들었습니다. 당연한걸 다시금 강조하고 싶은건, 여기는 광고와 “아무 상관없는” 부서이고, Search Engine이 움직이는 철학과 메커니즘은 사람들이 찾는 의도에 부합하는 검색결과를 보여주어, 사람들이 계속 Google 검색 엔진을 쓰도록 한다는거죠. 오로지 그걸 잘하기 위해 새로운 기술이나 알고리즘이 붙고(업데이트 되고), 검색결과의 모습도 바꿔보는거죠. Search 부문이 직접 돈을 받지 않지만, 이렇게 사람들이 계속 검색하러 들어와야 광고비즈니스가 존재할 수 있습니다. Search의 KPI는 광고비가 아니겠지만 광고의 근간이 되는 일을 하고 있습니다. KPI는 Search Quality를 측정하는 그들만의 무언가가 있으리라 봅니다.

좋은 검색결과의 기반은 크롤링 그리고 돈

헌데 Search Quality는 그냥 얻어지지 않습니다. 좋은 검색결과를 보여주는 것은 어마어마한 돈이 들어갑니다. 사람들이 검색하는데 가장 좋은 검색결과를 찾아내기 위해서는 ‘world widely하게 web으로 엮인 문서들을 모두 돌아다녀서 수집해서 가지고 있다가 당신이 검색하는 그 때 이해하기 쉬운 화면으로 전달’해야 하는 작업입니다.

전세계적으로 탄소저감 캠페인이 있을 때, Google은 ‘봇트래픽 및 불필요한 크롤링 감소’를 하고자 한다고 발표했습니다. 봇이 작업하러 다니는데 엄청난 에너지가 소모되고 있기 때문이죠. 그게 다 돈입니다.

Deep Dive 발표 내용중 2023년 spam 페이지가 하루에 400억개가 발견되었다고 했습니다. 한 페이지 크롤링을 10원으로 잡아도 하루에 4000억원의 크롤링 비용이 보여줄 수 없는 페이지에 지출되고 있는 상황입니다. Google은 기술적으로 앞선 회사이니, 페이지당 크롤링 단가가 이보다는 낮겠지만, 스팸이 아닌 정상페이지의 비중이 더 높을 것이고(hopefully), 그 페이지들의 크롤링 양을 다 포함해서 생각해보면, 크롤링 비용이 천문학적으로 소요된다는 것을 알 수 있습니다.

1998년 Google이 비즈니스를 시작할때부터 지속적으로 투자해오고 기술을 발전시켜왔기 때문에 비용효율성을 높이면서 현재도 전세계 웹페이지들을 계속 돌아다니고 정보를 수집할 수 있는 것이겠죠. Google의 성장 이후 유명을 달리한 검색엔진 기업들은 많지만 Google 성장 이후 필적할만하게 검색규모를 제공하는 기업이 출현하지 못하는 건 이유가 있을 것입니다. 기술적 난이도가 진입장벽일 수 있지만, 검색엔진은 scale이 중요하기 때문에 투자자원이 핵심인 것으로 보입니다. 우리나라의 Naver만 해도, 그렇게 돈이 많아 보여도, 그렇게 기술이 발전된 기업으로 보여도, 결국 한국어 검색엔진 버전만 운영하는 것은, globally 검색 사업을 전개할 수 있는 자금이 부족하거나 그 자금을 넣고도 돈을 벌 수 있는 계산이 나오지 않기 때문이겠지요.

옆길로 샌 듯한 이야기를 다시 Deep Dive로 되돌리자면, Google이 이번 Deep Dive 행사를 준비한 가장 중요한 이유는 결국 크롤링 때문일 것입니다. 직접 돈을 벌지 않는 부서는 비용을 효율적으로 사용하는게 매우 중요합니다. Google Search 부문은 훌륭한 검색결과를 위해 크롤링에 우리가 생각했던 것 보다 너무나 많은 비용을 지출하고 있을 것입니다. 아니, 사실 우리는 Google의 크롤링 비용에 대해 거의 생각하지 않고 있습니다. SEO한다는 분들도 ‘Crawling budget’에 관한 이야기는, ‘그래서 우리 사이트에 얼마나 자주오는데?’, ‘그래서 우리 사이트 페이지들은 다 못읽어간거면 크롤링 버짓이 없다는거야?’ 정도 수준의 이야기에 그치니까요. 그래서 Google Search 부분 멤버들은 이번 Deep Dive 행사에서 “Google은 크롤링에 자원을 너무나 많이 쓰고 있으니, 크롤링해서 가져온 내용이 훌륭한 답변을 제공하는데 기여하지 못한다면 그런 페이지는 만들지 마세요”라는 메시지를 강력하게 주고자 한 것 같았습니다.

행사 내내 강조된 크롤링

1일차 주제는 크롤링이었구요, 2일차, 3일차에는 웹페이지가 쓸만한 내용인지 검토하는 과정에 대한 이야기를 들려주었습니다. 하지만 3일 내내 강조되고 있던 이야기는 크롤링 자원이 많이 드니 http status를 정확히 알고 있어야 하고 스팸이 아닌 신뢰할 수 있는 페이지를 만들라는 이야기가 반복되었습니다.

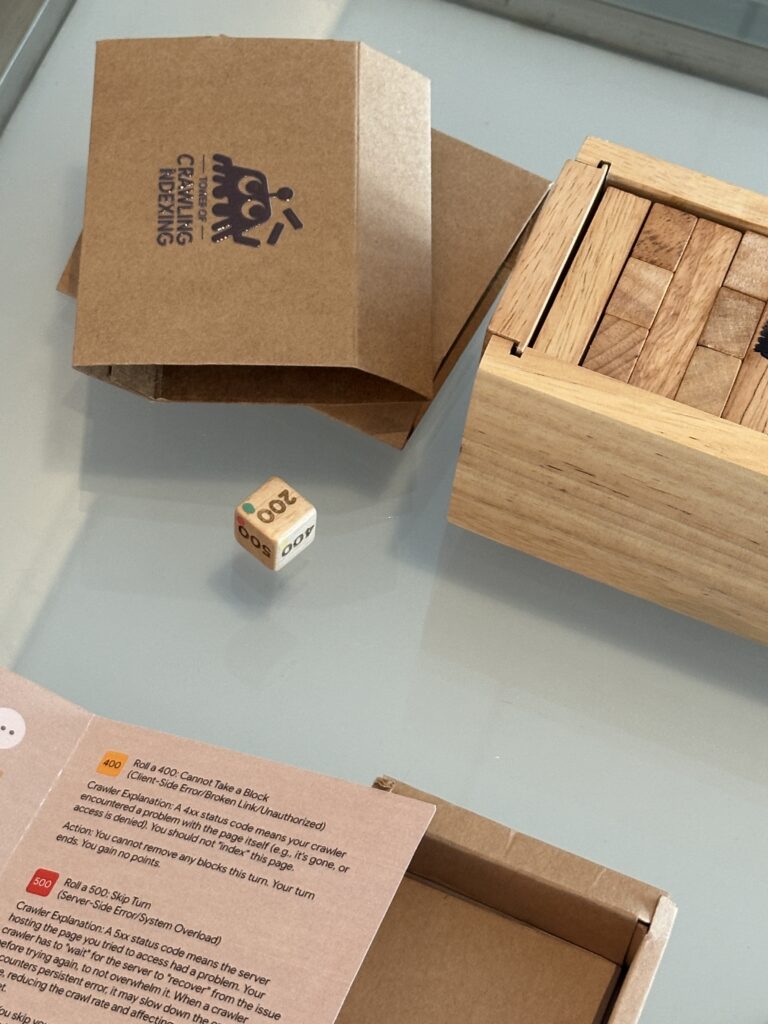

특히 http status에 대해서는 Search Advocate 대표 선수인 Gary가 소소하게 video game을 두 개나(!) 만들어서 참가자들의 머릿속에 http status 이슈가 각인되도록 했고, 보드게임도 만들어서 http status에 따라 게임을 진행하도록 했습니다. (http status 이슈에 관한 글 링크)

이토록 크롤링과 그 비용을 강조하는 이유가 전체 Search 프로세스 중 비용이 가장 많이 드는 영역이기 때문일까요? 그건 아닐 수도 있습니다. 비용은 다른 프로세스에 더 많이 들어갈 수 있습니다.

우선 간단히 다른 프로세스를 이야기 해보자면 이렇습니다. Google은 이렇게 크롤링해온 것을 Google 머릿속에 차곡차곡 정리해놓습니다. 이걸 인덱싱이라고 합니다. 검색자가 검색하는 순간 인덱싱 된 데서 가장 잘 매치되는 페이지들을 보여주는 것을 서빙이라고 합니다. 그걸 어떤 순위로 제공하느냐가 랭킹이죠.

인덱싱이나 서빙의 퀄리티를 높이는건 Google이 내부적으로 잘 하면 됩니다. 헌데 크롤링은 효율성 controlability가 전세계 웹페이지들에 달려있습니다. 고품질 검색결과를 제공하려면(그리고 나아가 Genmini에게 끊임없이 좋은 학습자료를 제공하려면), 전세계 웹사이트를 모두 돌아다녀서 내용을 끌어모아야 그중 가장 좋은 것을 알려줄 수 있습니다. 그것이 Google 검색의 경쟁력 중 하나입니다(네이버는 그에 비해 소규모 웹페이지들을 크롤링해서 아쉽게도 검색 경쟁력이 떨어지죠). 전세계 웹페이지들을 크롤링하는데는 spammy 페이지들도 다 들어가봐야 하니 낭비가 심하죠. 하지만 그런 spammy들은 Google이 만들고 관리하는게 아니라서 controlability가 떨어집니다. Google 내부적으로 잘 하는 것만으로는 어려움이 있습니다. 비용의 크기도 문제고 관리 어려움도 있다는거죠.

여기서 전세계에서 검색엔진에 관심을 갖고 비즈니스를 수행하는 많은 전문가들의 도움이 필요해집니다. 전세계 웹페이지 관리를 검색엔진 최적화 관점에서 하고있는 SEO 커뮤니티가 Google Search 부문에게는 너무나 소중한 사업 파트너인거죠. 품질 좋은 웹페이지를 만드는데 관심있는 SEO 커뮤니티가 결국 Google의 에서 품질 좋은 페이지들이 만들어 크롤링 자원을 효율적으로 쓸 수 있도록 도와주는 외부 지원군입니다. 외부의 전문가들이 크롤링 자원이 낭비되지 않는 웹 생태계를 만드는데 기여할 것이라는 강력한 믿음이 이번 행사를 가능하게 했을 것으로 보입니다.

참가비도 없는 행사에서 맛난 점심 주고, 간식주고, 기념품 주고, 선물주고…. 이 모든걸 해주는 명분이 SEO 커뮤니티를 계몽, 혹은 교육 하여 크롤링 버짓을 낭비하지 않는 것이 얼마나 중요한지 이야기 할 수 있었기 때문입니다.

아마 Gary나 Cherry는 이번 행사 준비에서 그런 보고서를 올렸겠지요. 이번 행사를 통해 SEO 커뮤니티에 크롤링에 대한 이야기를 잘 알려주면, 크롤링 효율화에 장기적으로 얼마정도 기여할 것이고, 그러니 이들과 함께 하는 venue와 점심식사 비용은 어느정도 선이 적당하겠다….고, 말입니다.

GenAI 시대에 폭증하는 콘텐츠, 폭증하는 크롤링 비용

크롤링의 일반적인 중요성에 덧붙여 한가지 그냥 지나갈 수 없는 큰 변화가 있습니다. 바로 GenAI죠. GenAI 시대가 Google의 Crawling budget에 의미하는 바가 무엇이겠습니까? ‘GenAI 덕분에 이제 콘텐츠 생산이 너무 쉬워져서 웹페이지가 “마구잡이”로 생성될 것이고, 그 많이 페이지들을 다 크롤링하자니 Google의 크롤봇이 그걸 어찌 감당하나…’하는 걱정이겠지요. Google은 GenAI 시대에 폭증하는 web 콘텐츠를 다 크롤링하여 보다 나은 검색 결과를 제공하기 위해서 크롤링 자원을 무한정 늘일 수 없습니다. 크롤링 버짓을 어떻게 관리할 것인가 하는 Google의 고민이 깊어지게 된 상황이 바로 지금 2025년에 행사를 가능하게 만든 기폭제였을 것입니다.

AI 시대 크롤봇은 이전 크롤봇과 달리 더 똑똑하긴 합니다. Javascript도 읽을 수 있고, 이미지도 읽을 수 있으니까요. 하지만 Javascript와 이미지를 읽기 위해서는 일반 html text를 읽는 것보다는 자원이 더 많이 들어갑니다. 웹페이지들이 JS와 이미지를 많이 쓰니 읽긴 읽어야겠고, 하~ 이제 비디오도 읽어야 합니다. Google은 크롤봇을 보낼 때 텍스트 읽는 agent와 image, video를 읽는 agent를 별도로 기용하고 있습니다. Vision algorithm이 같이 다니는데, 아무래도 text 읽는 것보다는 처리해야 할 정보가 많으니 하다못해 전기세라도 더 나가는 고비용 구조이겠죠.

그래서 이번 행사에서는 Javascript 콘텐츠, GenAI가 생성하는 콘텐츠, multi modal 콘텐츠 등에 대한 이야기도 같이 다루고 있습니다. 구체적인 내용은 행사에 참석했던 어센트코리아 멤버들의 다른 글에서 더 다루고, 크롤링 비용을 심각하게 보고 있는 Google에 보조를 맞추기 위해 기업은, 기업의 마케터는 어떤 실행을 해야 하는지 살펴보겠습니다.

크롤링 자원 문제가 우리와 무슨 상관이 있다고?

Google이 크롤링자원에 대해 이런 심각한 고민을 한 나머지 spammy contents를 잘 걸러낼 수 있는 update를 중요한 update로 진행합니다.

- 보통의 기업들은 spammy contents를 대량생산하거나 backlink를 왕창 걸어 검색 노출을 높여보겠다는 심산에서 junky한 콘텐츠가 가득한 ‘각종 정보 가득 웹사이트’ 등을 만들지 않습니다. 다만, Google이 오인지할만한 요소들이 우리 기업의 웹페이지에 존재할 수 있으므로 주의깊게 살펴 불이익이 없도록 해야 합니다. 특히나 SEO의 검은 방법론으로 일시적인 성과 증대를 위해 backlink를 abusing하는 전문가를 만나서 사이트 전체가 오래 악영향을 받는 일이 없어야 합니다.

- 기업의 웹사이트 관리 담당자는 우선 기업의 웹사이트가 검색엔진이 제대로 크롤링 해 가는지 정확히 이해하고 있어야 합니다. Crawling agent, crawl bot 들의 행태를 정확히 이해하고 그에 맞게 웹사이트를 관리할 수 있어야 합니다. Google은 크롤링 컨디션을 Google Search Console에서 상세하게 이해할 수 있도록 분석데이터를 제공하고 있습니다. Google은 Search Center 사이트를 두어 검색 방식과 세부적인 실행방안, 개발 가이드 등을 안내하고 유튜브 Search Central 채널을 통해 지속적인 정보 제공과 office hour를 운영하고 있습니다. 웹사이트 관리 담당자가 크롤링 로직을 이해하고 관리해야 우리 웹사이트가 가진 모든 페이지가 Google이 알고 있는 페이지가 되도록 만들수 있습니다. 검색엔진이 모르는 페이지는 새로운 고객의 유입 가능성이 없는 페이지이기 때문이죠. (세부 내용은 크롤링 예산에 대한 글 참조하세요)

- AI로 생성한 콘텐츠를 포함하여 질보다 양으로 승부하는 콘텐츠 생산은 지양해야합니다(Google이 대접한 맛난 식사 밥값을 하는 참여자로서 말씀드립니다). 품질이 낮은 콘텐츠는 우리 사이트가 가진 크롤링 자원을 낭비하는 것입니다. 남의회사(Google)의 자원 낭비라 괜찮은 것이 아니라 우리 회사 웹사이트의 다른 중요한 페이지가 읽힐 수 있는 기회를 빼앗게 됩니다.

- 끝으로 AI로 콘텐츠를 생산하더라도, 누군가의 검색에 충분히 답변이 될 콘텐츠를 만들어야 합니다. 이미 답변을 잘 하고 있는 다른 콘텐츠들보다 한방울의 가치를 더하는 내용이라면 AI가 만들건 문어가 만들건 상관없습니다.

Google에게 검색결과 품질은 Google의 자존심이 아니라 Google의 밥줄입니다. 좋은 검색결과 품질은 크롤링 경쟁력에서 생깁니다. 그리고 그 경쟁력은 Google의 LLM 사용모델인 Gemini의 품질에도 영향을 미칩니다. 좋은 학습 데이터를 선별하지 못하면 말도안되는 hallucination을 내뱉을 수 있기 때문입니다. 이 모든 것의 시작은 크롤링입니다. 아무리 Open AI가 치고 나온 상황이어도 Google이 가진 크롤링 경쟁력은 Gemini가 금방 뒤엎을 수 있는 기반을 제공합니다. Google은 크롤링 할 때, javascript도 풀어 읽어내고, 이미지도, 비디오도 읽어갈 수 있으니까요.

Google은 왜 Search Central Live Deep Dive Asia Pacific 행사를 열었을까? 이 질문을 Google에게 던져본다면 그들은, 중요한 세가지 이유를 아래처럼 답변할 것 같습니다.

‘Crawling! Crawling!! Crawling!!!’